Projet de

Migration de flux

de données communes au sein d'une

application de BigData

de données communes au sein d'une

application de BigData

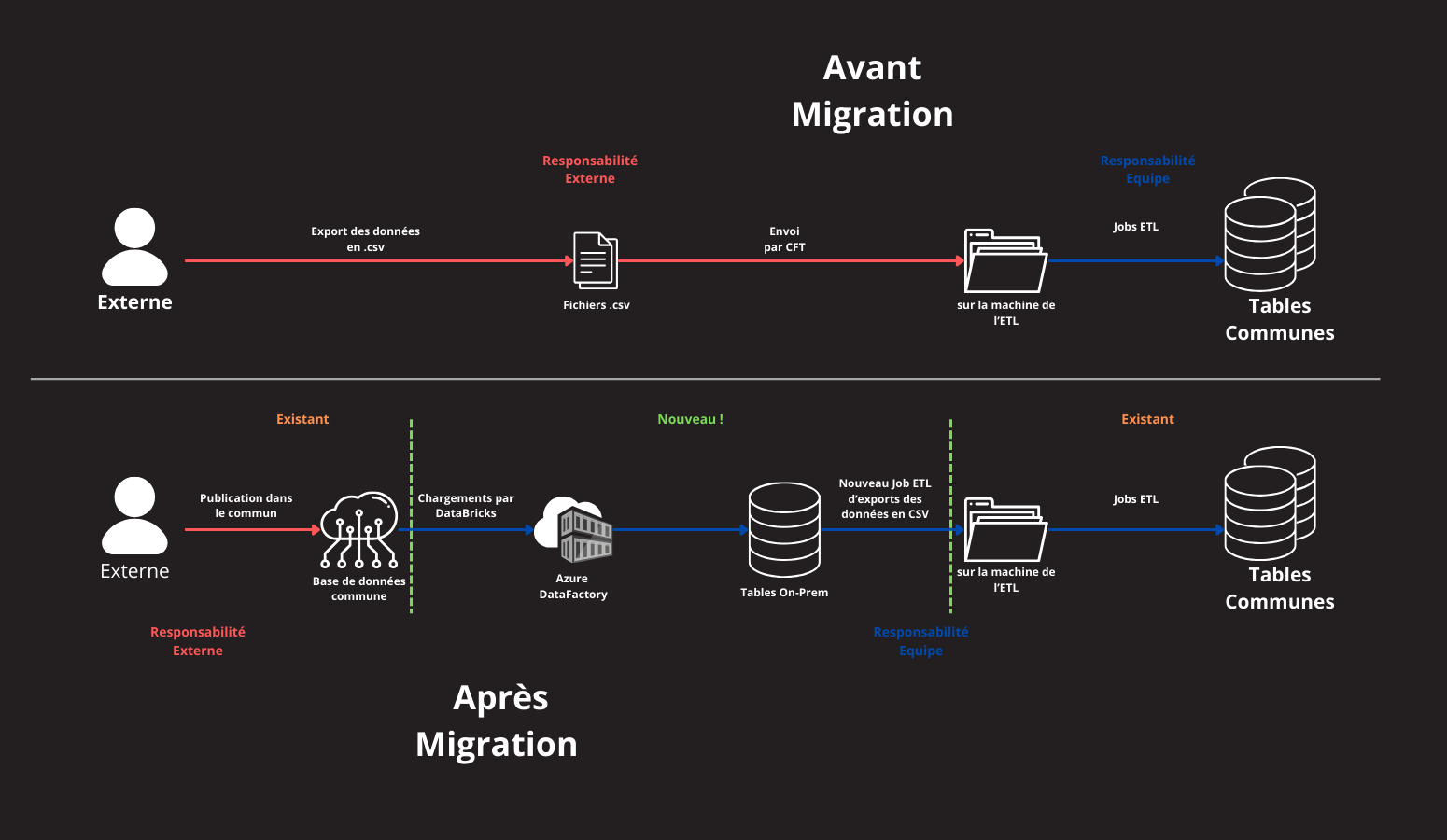

Pendant mon projet d'alternance, j'ai eu l'opportunité de participer à l'expérimentation et à la mise en place de la migration d'un flux de données vers une nouvelle technologie en utilisant Azure DataFactory et DataBricks. Ce projet a impliqué plusieurs phases, chacune nécessitant des compétences techniques et organisationnelles spécifiques.

Compréhension des Besoins et Choix de la Solution : Au début du projet, notre équipe a identifié que la méthode actuelle de distribution des données par envoi de fichiers était inefficace. Nous avons donc étudié diverses solutions alternatives. Initialement, nous avons envisagé l'utilisation de topics pour consommer les données. Cependant, cette technologie n'était pas utilisée de notre côté, ce qui nous a poussés à nous tourner vers Azure. Azure avait l'avantage d'offrir un accès direct aux tables de données tant du côté distributeur que de notre application.

Compétence : Partir des exigences et aller jusqu’à une application complète : Analyse des besoins et sélection de la solution Azure.

Conception et Mise en Œuvre de l'Infrastructure : Une fois la solution Azure choisie, nous avons créé de nouvelles tables intermédiaires pour stocker les données de manière journalière. Ces tables servaient d'étape de transition avant de passer les données par un ETL (Extract, Transform, Load) pour les formater correctement.

Compétence : Optimiser une base de données, interagir avec une application et mettre en œuvre la sécurité : Création et optimisation des bases de données intermédiaires, avec des mesures de sécurité adéquates.

Phase d'Expérimentation et Validation : Nous avons conduit une phase d'expérimentation pour valider la nouvelle méthode de transfert de données. Cette phase a permis de tester l'efficacité des flux Azure et de vérifier que les données étaient correctement transformées et réintégrées dans les fichiers finaux sans altérer les processus existants.

Compétence : Appliquer une démarche de suivi de projet en fonction des besoins métiers des clients et des utilisateurs : Suivi de l'avancement et retour d'expérience pour ajuster les processus.

Déploiement et Transition : Après la phase de test, nous avons multiplié l'opération aux différents flux et procédé à leur déploiement dans les environnements de production. Une fois les nouveaux flux en place, nous avons désactivé l'ancienne méthode d'envoi de fichiers.

Compétence : Déployer des services dans une architecture réseau : Mise en place des flux dans les environnements de production.

Gestion des Difficultés : Le projet a présenté plusieurs défis, notamment l'apprentissage rapide des nouvelles technologies Azure et la gestion des différences de format entre les fichiers originaux et les données finales. Il était crucial de maintenir l'intégrité des données pour éviter tout impact négatif sur les processus suivants.

Compétence : Situer son rôle et ses missions au sein d’une équipe informatique : Collaboration avec les membres de l'équipe pour assurer une transition en douceur.

Conclusion : Ce projet d'alternance a été une expérience enrichissante où j'ai pu mettre en œuvre et développer un ensemble de compétences techniques et organisationnelles. La migration vers Azure DataFactory et DataBricks a permis d'améliorer l'efficacité des transferts de données tout en garantissant la continuité et la fiabilité des processus existants. Cette expérience m'a également permis de travailler en étroite collaboration avec mon équipe, de gérer de manière autonome mes tâches, et d'acquérir une vision complète d'un projet de migration de données.

En résumé, ce projet m'a offert une expérience précieuse en matière de gestion de données, de nouvelles technologies, et de travail en équipe, tout en contribuant activement au succès de l'initiative de migration.